- 카카오톡 운영 경험 기반 `독자 AI 파운데이션 모델 프로젝트` 박차

- 이미지 이해 능률 탁월한 `Kanana-1.5-v-3b`…GPT-4o와 견줄 성능 과시

- 비용 효율 혁신 `MoE 모델` 국내 첫 공개…AI 개발 트렌드 선도

카카오가 자체 개발한 AI 기술력을 다시 한번 입증하며 국내 AI 생태계에 새로운 활력을 불어넣고 있다. 지난 5월 언어모델 4종 공개에 이어 약 두 달 만에 국내 공개 모델 중 최고 성능을 자랑하는 경량 멀티모달 언어모델과 국내 최초로 MoE(Mixture of Experts) 모델을 오픈소스로 공개했다고 24일 밝혔다.

카카오(대표이사 정신아)는 24일 허깅페이스를 통해 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델 `Kanana-1.5-v-3b`와 MoE 언어모델 `Kanana-1.5-15.7b-a3b`를 공개했다.

카카오(대표이사 정신아)는 24일 허깅페이스를 통해 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델 `Kanana-1.5-v-3b`와 MoE 언어모델 `Kanana-1.5-15.7b-a3b`를 공개했다.

카카오(대표이사 정신아)는 오늘 허깅페이스를 통해 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델 `Kanana-1.5-v-3b`와 MoE 언어모델 `Kanana-1.5-15.7b-a3b`를 공개했다. 이는 카카오가 독자적인 모델 설계 기반의 기술 경쟁력을 지속적으로 강화하고 있음을 보여주는 대목이다.

정부가 추진하는 `독자 AI 파운데이션 모델 프로젝트`에 참여하고 있는 카카오는 이러한 자체 모델 개발 역량과 카카오톡 등 대규모 서비스 운영 경험을 바탕으로 전 국민의 AI 접근성을 높이고 국가 AI 경쟁력 강화에 기여하겠다는 방침이다.

이미지와 텍스트를 동시에 처리하는 경량 멀티모달 언어모델 `Kanana-1.5-v-3b`는 지난 5월 공개된 Kanana 1.5 모델을 기반으로 한다. 이 모델은 개발의 처음부터 마지막 단계까지 카카오의 자체 기술로 구축하는 `프롬 스크래치(From Scratch)` 방식으로 개발되었다.

`Kanana-1.5-v-3b`는 이용자의 질문 의도를 정확히 이해하는 높은 지시 이행 성능과 뛰어난 한국어·영어 이미지 이해 능력을 자랑한다.

경량 모델임에도 이미지로 표현된 한국어와 영어 문서 이해 능력은 글로벌 멀티모달 언어모델인 GPT-4o와 견줄 만한 수준이며, 한국어 벤치마크에서는 유사 사이즈의 국내외 공개 모델 중 최고 점수를 기록했다.

카카오는 인간 선호 반영 학습(Human Preference Alignment Training)과 지식 증류(Knowledge Distillation) 기술을 통해 이 모델의 성능을 극대화했다고 설명했다.

이를 통해 `Kanana-1.5-v-3b`는 이미지 및 글자 인식, 동화 및 시 창작, 국내 문화유산 및 관광지 인식, 도표 이해, 수학 문제풀이 등 다양한 분야에서 유연하게 활용될 수 있다.

이와 함께 카카오는 국내 최초로 MoE(Mixture of Experts) 구조의 언어모델 `Kanana-1.5-15.7b-a3b`를 오픈소스로 공개했다. MoE 모델은 입력 데이터 처리 시 모든 파라미터가 연산에 참여하는 기존 `밀집(Dense)` 모델과 달리, 특정 작업에 최적화된 일부 전문가 모델만 활성화되어 컴퓨팅 자원 활용 효율성과 비용 절감에 강점을 가진다.

이러한 장점으로 MoE는 글로벌 AI 모델 개발의 새로운 트렌드로 자리 잡고 있다. `Kanana-1.5-15.7b-a3b`는 전체 15.7B 파라미터 중 추론 시 약 3B 파라미터만 활성화되며, `업사이클링(Upcycling)` 방식을 적용해 효율적으로 개발되었다.

활성화되는 파라미터가 3B에 불과함에도 성능은 `Kanana-1.5-8B`와 동등하거나 그 이상을 기록해, 고성능 AI 인프라를 저비용으로 구축하고자 하는 기업이나 연구 개발자들에게 큰 도움이 될 것으로 기대된다.

카카오는 이번 오픈소스 공개를 통해 AI 모델 생태계에 새로운 기준을 제시하고, 더 많은 연구자와 개발자가 효율적이고 강력한 AI 기술을 자유롭게 활용할 수 있는 기반을 마련해 나갈 계획이다.

김병학 카나나 성과리더는 "이번 오픈소스 공개는 비용 효율성과 성능이라는 유의미한 기술 개발의 성과를 거둔 것으로, 단순한 모델 아키텍처의 진보를 넘어 서비스 적용과 기술 자립이라는 두 가지 측면의 목표에 부합하는 결과물"이라고 밝혔다.

카카오는 자체 기술 기반의 모델을 지속적으로 고도화하고, 글로벌 플래그십 수준의 초거대 모델 개발에 도전하며 국내 AI 생태계의 자립성과 기술 경쟁력 강화에 기여할 방침이다.

‘세계를 이끌 녹색의 새 물결’ 건대 정시 합격자 1374명 발표

건국대학교는 2월 2일 2026학년도 신입생 정시모집 정원 내 KU일반학생 전형 및 정원 외 농어촌학생 전형, 기초생활및차상위 전형 등 최초 합격자 1374명을 발표했다. 전형별로 정원 내에서는 KU일반학생 전형 ‘가’군이 423명 모집에 2538명 지원해 6대1의 경쟁률을 기록했다. ‘나’군은 578명 모집에 4098명이 지원해 7.09대1이며, ‘다’군은 230명 모집에 2339명이 지원해 10.17대1로 KU일반학생 전형 중 경쟁률이 가장 높았다. 정원 외 농어촌학생 전형은 ‘가’군이 27명 모집에 192명 지원으로 7.11대

‘세계를 이끌 녹색의 새 물결’ 건대 정시 합격자 1374명 발표

건국대학교는 2월 2일 2026학년도 신입생 정시모집 정원 내 KU일반학생 전형 및 정원 외 농어촌학생 전형, 기초생활및차상위 전형 등 최초 합격자 1374명을 발표했다. 전형별로 정원 내에서는 KU일반학생 전형 ‘가’군이 423명 모집에 2538명 지원해 6대1의 경쟁률을 기록했다. ‘나’군은 578명 모집에 4098명이 지원해 7.09대1이며, ‘다’군은 230명 모집에 2339명이 지원해 10.17대1로 KU일반학생 전형 중 경쟁률이 가장 높았다. 정원 외 농어촌학생 전형은 ‘가’군이 27명 모집에 192명 지원으로 7.11대

GS샵, 1등 브랜드 ‘코어 어센틱’ 잡화까지 확장… 토탈 패션 브랜드로 키운다

GS리테일이 운영하는 홈쇼핑 채널 GS샵이 자체 패션 브랜드 ‘코어 어센틱(CHOR AUTHENTIC)’ 카테고리를 의류에서 슈즈, 가방 등 잡화까지 확장하며 토탈 패션 브랜드 육성에 나선다. 2024년 GS샵이 론칭한 코어 어센틱은 ‘절제된 것이 가장 아름답다’는 철학하에 미니멀리즘을 추구하는 고객 니즈에 맞춰 심플한 라인과 고급스러운 소재를 강조한 자체 패션 브랜드다. ‘코어로 완성되는 올코디네이션 룩킹’ 콘셉트로 차별화에 성공한 결과, 코어 어센틱은 2025년 전년 대비 175%의 성장률을 기록하며 누적 주문액 950억원을 달

GS샵, 1등 브랜드 ‘코어 어센틱’ 잡화까지 확장… 토탈 패션 브랜드로 키운다

GS리테일이 운영하는 홈쇼핑 채널 GS샵이 자체 패션 브랜드 ‘코어 어센틱(CHOR AUTHENTIC)’ 카테고리를 의류에서 슈즈, 가방 등 잡화까지 확장하며 토탈 패션 브랜드 육성에 나선다. 2024년 GS샵이 론칭한 코어 어센틱은 ‘절제된 것이 가장 아름답다’는 철학하에 미니멀리즘을 추구하는 고객 니즈에 맞춰 심플한 라인과 고급스러운 소재를 강조한 자체 패션 브랜드다. ‘코어로 완성되는 올코디네이션 룩킹’ 콘셉트로 차별화에 성공한 결과, 코어 어센틱은 2025년 전년 대비 175%의 성장률을 기록하며 누적 주문액 950억원을 달

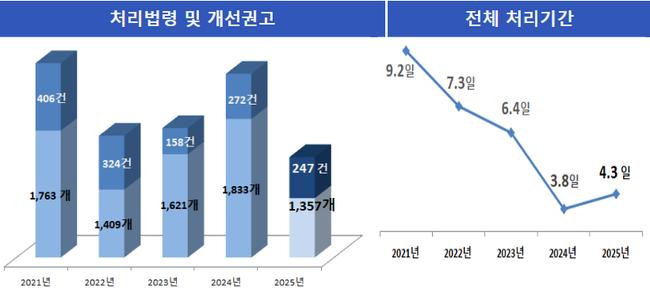

예측 어려운 법령이 부패 부른다…권익위, 입안 단계부터 차단

예측 어려운 법령이 부패 부른다…권익위, 입안 단계부터 차단

더존비즈온, 연매출 4,463억·영업익 1,277억…사상 최대

더존비즈온, 연매출 4,463억·영업익 1,277억…사상 최대

티젠소프트, 중앙노동위원회 대량메일발송솔루션 구축

티젠소프트, 중앙노동위원회 대량메일발송솔루션 구축

한국백혈병어린이재단, 소아암 환자 가족에 마스크 21만장 긴급 지원

한국백혈병어린이재단, 소아암 환자 가족에 마스크 21만장 긴급 지원

목록

목록